MiKlo:~/citizen4.eu$💙💛udostępnił to.

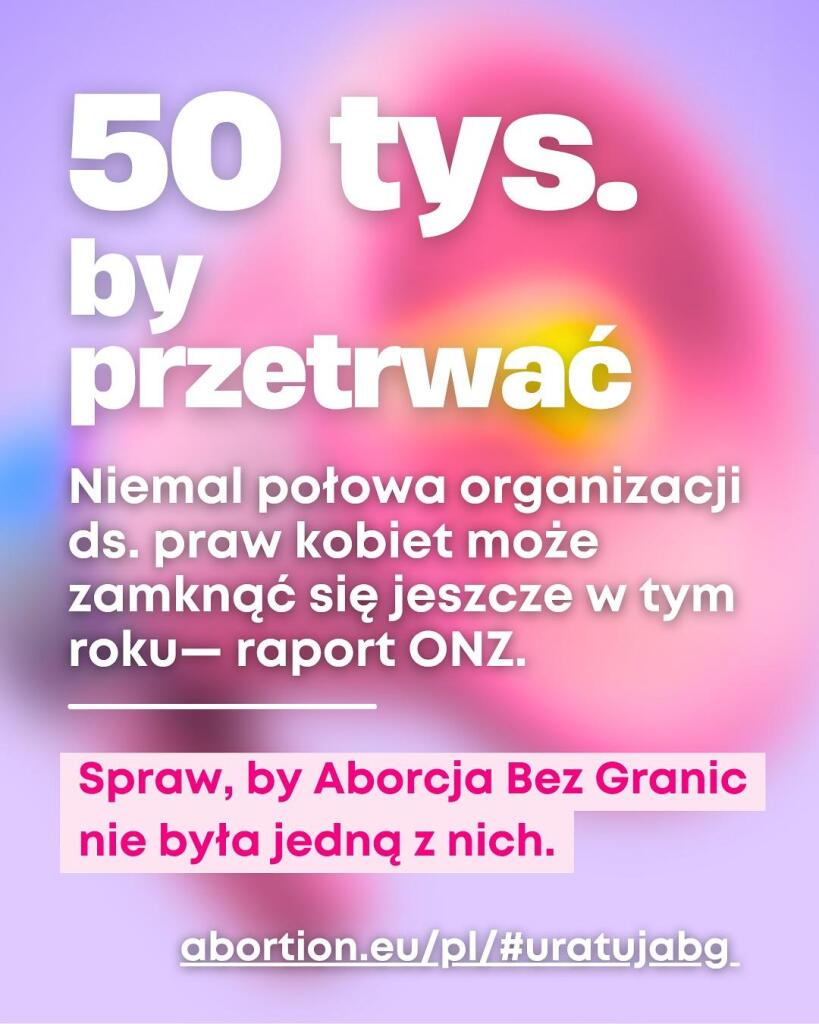

Raport UN Women wskazuje, że 47% organizacji zajmującymi się prawami kobiet może nie przetrwać 2025 roku z powodu braku funduszy. Zmiany polityczne, inflacja, wojny, Trump na czele USA, skręcanie w prawo całej Unii Europejskiej to tylko niektóre powody.

Czas uratować infolinię Aborcji Bez Granic. Zmiana władzy w Polsce dwa lata temu, inflacja, ograniczenia grantowe sprawiły że musimy prosić was o pomoc.

Potrzebujemy zebrać 50 000 euro do końca 2025, aby infolinia przetrwała oraz żebyśmy nie musiały nikomu odmówić pomocy w dostępie do aborcji.

Aborcja Bez Granic to infolinia z numerem 22 29 22 597. Od niemal 6 lat, codziennie od 8:00 do 20:00, 7 dni w tygodniu, 365 dni w roku, osoby przebywające z Polski dzwonią na ten numer, gdy potrzebują aborcji.

Aborcja Bez Granic pomaga 130 osobom w Polsce codziennie w dostępie do bezpiecznej aborcji. Dzięki tej międzynarodowej sieci, to właśnie te kobiety, których nie stać na bezpieczną aborcje, mogły ją uzyskać.

Od niemal 6 lat kierujemy się zasadą, że brak pieniędzy na aborcje nie powinien być nigdy powodem, by zostać zmuszonym do rodzicielstwa. Przez cały okres swojego istnienia wydałyśmy ponad 3 miliony złotych na zabiegi aborcji. Jednak nasza możliwości finansowe mocno się skurczyły 🙁

Bez Waszego wsparcia nasza infolinia będzie musiała zostać zamknięta a my będziemy zmuszone odmawiać pomocy w organizacji wyjazdów i zabiegów 💔

Ratujmy naszą infolinię!

Darowiznę możesz przekazać tutaj:

https://abortion.eu/pl/#uratujabg

Donation link English: https://abortion.eu/#save-awb

#aborcja #AborcjaBezGranic #pomoc #wsparcie #zrzutka #uratujABG #uratujAborcjęBezGranic @aborcja

Aborcja Bez Granic

to źródło informacji oraz praktycznego i finansowego wsparcia dla osób w Polsce, które potrzebują aborcji w kraju (poprzez uzyskanie informacji o bezpiecznych tabletkach poronnych) i poza jego granicami (zabieg w klinice).Aborcja Bez Granic

harc lubi to.

4 użytkowników udostępniło to dalej

MiKlo:~/citizen4.eu$💙💛udostępnił to.

https://truthout.org/articles/trumps-ice-turns-its-target-to-activists-not-just-immigrants/

Trump’s ICE Has Started Targeting Activists, Not Just Immigrants

ICE demanded Meta hand over personal information attached to Instagram accounts that track immigration raids.Mike Ludwig (Truthout)

2 użytkowników udostępniło to dalej

MiKlo:~/citizen4.eu$💙💛udostępnił to.

Powodem jest to, że odpalony jest także runner przetwarzający materiały audiowizualne na Kontrabandzie Play -- gdyż stojący na osobnej maszynie frontend PeerTube'a się po prostu na tym dławi. Niestety, jest to dość zasobożerne.

Wiem, że są cele, które wymagają większej pilności -- jednak chciałbym się przygotować na wywiad pod koniec października z prezesem fundacji „Dzieci są z nami” (co zapowiadałem ~2 dni wcześniej), który będzie nadawany na właśnie Kontrabandzie Play.

Dla tych, którzy się dopiero co dowiadują o „Kontrabandzie” -- jest to medium obywatelskie, prowadzone oddolnie i planujemy uruchomienie telewizji internetowej.

Z góry dzięki!

https://patronite.pl/kontrabanda.net lub https://buycoffee.to/kontrabanda

* 8 vcore, 24 GB RAMu, 200 GB przestrzeni dyskowej

#MutualAid

kontrabanda.net

O otwartej technologii jeszcze nikt się tak nie rozpisywał – i do tego po polsku.Patronite.pl

2 użytkowników udostępniło to dalej

(i tak, zależy mi na tym, żeby dane były przechowywane wewnątrz granic Polski)

MiKlo:~/citizen4.eu$💙💛udostępnił to.

Go back and read the live blog in full. You need to know their own actual words. https://www.theguardian.com/us-news/live/2025/sep/30/us-government-shutdown-funding-trump-vance-portland-hegseth-latest-updates?CMP=Share_iOSApp_Other

Trump suggests ‘dangerous’ US cities should be used as ‘training grounds’ in extraordinary speech to military leaders – live

US president tells hundreds of generals and admirals in Virginia they will ‘straighten out’ US cities after Pete Hegseth rails against ‘fat troops’Lucy Campbell (The Guardian)

2 użytkowników udostępniło to dalej

MiKlo:~/citizen4.eu$💙💛udostępnił to.

F-Droid sees Google's plans as a threat to FOSS apps.

https://arstechnica.com/gadgets/2025/09/f-droid-calls-for-regulators-to-stop-googles-crackdown-on-sideloading/?utm_brand=arstechnica&utm_social-type=owned&utm_source=mastodon&utm_medium=social

F-Droid says Google’s new sideloading restrictions will kill the project

F-Droid sees Google’s plans as a threat to FOSS apps.Ryan Whitwam (Ars Technica)

2 użytkowników udostępniło to dalej

MiKlo:~/citizen4.eu$💙💛udostępnił to.

"If you don't like Apple's locked down system, just by an Android phone."

"If you don't like what Google is doing to Android, just fork the OS; it's open source!"

"It doesn't matter that banking and payment apps require a verified device. No real users have custom ROMs; just zealots and hackers."

"No, you can't just install whatever you want on your own device. What if someone gets tricked into disabling the four layers of protection and installing spyware? We have to protect them."

"Oh wow, I have to buy an expensive approved device that spies on me and doesn't let me run the software I want, in order to pay my rent? Who could have seen this coming?"

Do you understand why we get upset when people don't take our concerns seriously?

10 użytkowników udostępniło to dalej

MiKlo:~/citizen4.eu$💙💛udostępnił to.

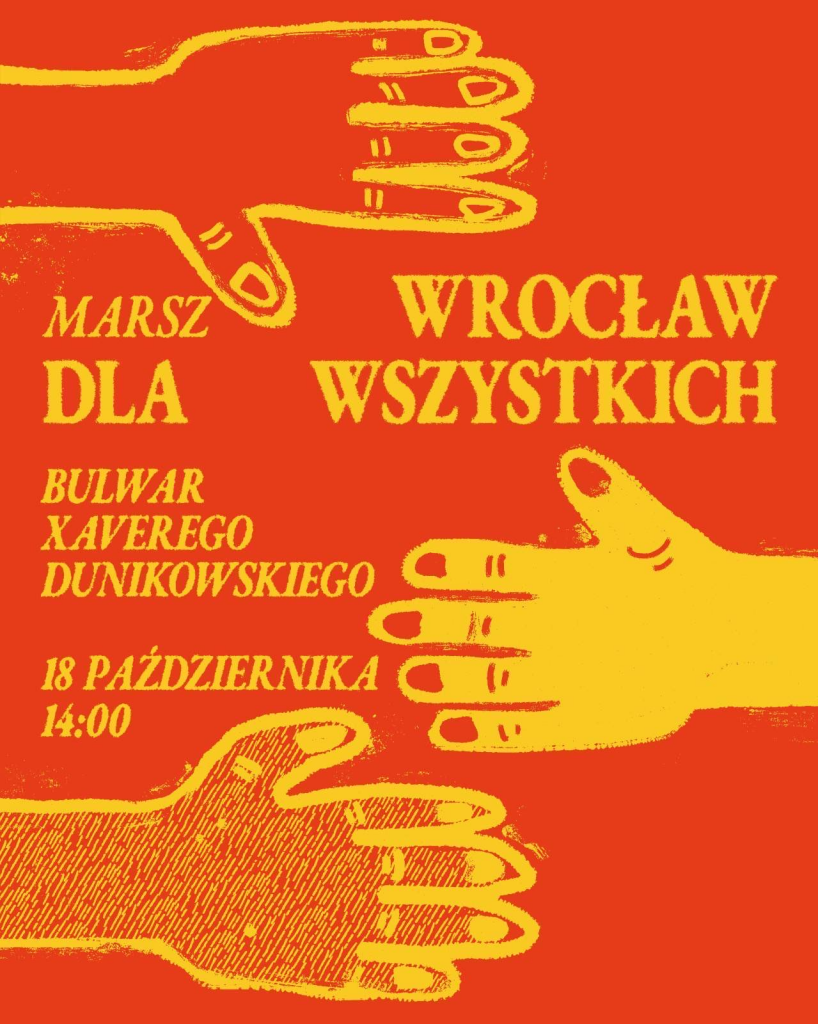

Marsz antyrasistowski | 18.10.2025 | 14:00–17:30

Spotkajmy się, aby wspólnie stworzyć przestrzeń radości, solidarności i otwartości. Przyjdźmy z rodzinami, przyjaciółkami i sąsiadami – każdy i każda z nas jest częścią tego miasta. Wrocław jest domem, w którym żyjemy, czasem z wyboru, czasem z konieczności, ale zawsze – z prawem do bezpieczeństwa, szacunku i godności.

Nasz marsz to barwna, różnorodna manifestacja wspólnoty i solidarności. To radosny taniec, ale też mocne i jasne stanowisko: w obliczu rasizmu, ksenofobii, homofobii, mizoginii i każdej formy przemocy – wybieramy solidarność, równość i życie wolne od lęku.

Wychodzimy na ulice,

- bo rasizm nie jest opinią – jest systemem, który krzywdzi ludzi,

- bo nienawiść nie może definiować przestrzeni, w której żyjemy,

- bo równość i wolność wymagają wspólnego działania,

- bo Wrocław jest wspólnotą a różnorodność mieszkanek i mieszkańców jest jego siłą,

- bo jesteśmy odpowiedzialni i odpowiedzialne za swoje wzajemne bezpieczeństwo – niezależnie od koloru skóry, pochodzenia, języka, religii, orientacji, tożsamości czy statusu pobytowego.

Kiedy: sobota, 18 października 2025

Godzina: 14:00–17:30

Start: Bulwar Dunikowskiego

Weź ze sobą transparent, instrument, kolorowe ubrania i bliskich.

Dołącz i pokażmy, że Wrocław należy do wszystkich!

Dołączysz?

Wrocław for Everyone – Without Hatred

Anti-racism march | 18 October 2025 | 2:00–5:30 p.m.

Let's meet to create a space of joy, solidarity and openness together. Let's come with our families, friends and neighbours – each and every one of us is part of this city. Wrocław is the home we live in, sometimes by choice, sometimes by necessity, but always with the right to safety, respect and dignity.

Our march is a colourful, diverse manifestation of community and solidarity. It is a joyful dance, but also a strong and clear statement: in the face of racism, xenophobia, homophobia, misogyny and all forms of violence, we choose solidarity, equality and a life free from fear.

We take to the streets

- because racism is not an opinion – it is a system that harms people,

- because hatred cannot define the space in which we live,

- because equality and freedom require joint action,

- because Wrocław is a community and the diversity of its residents is its strength,

- because we are responsible for each other's safety – regardless of skin colour, origin, language, religion, orientation, identity or residence status.

When: Saturday, 18 October 2025

Time: 2:00–5:30 p.m.

Start: Bulwar Dunikowskiego

Bring a banner, an instrument, colourful clothes and your loved ones.

Join us and let's show that Wrocław belongs to everyone!

Will you join us?

Вроцлав для всіх – без ненависті

Антирасистський марш | 18.10.2025 | 14:00–17:30

Зустріньмося, щоб разом створити простір радості,

солідарності та відкритості. Прийдімо з родинами, друзями та сусідами – кожен і кожна з нас є частиною цього міста. Вроцлав – це дім, в якому ми живемо, іноді за власним вибором, іноді з необхідності, але завжди – з правом на безпеку, повагу та гідність.

Наш марш – це барвиста, різноманітна маніфестація спільноти та солідарності. Це радісний танець, але також сильна і чітка позиція: перед обличчям расизму, ксенофобії, гомофобії, мізогінії та будь-якої форми насильства – ми обираємо солідарність, рівність і життя без страху.

Ми виходимо на вулиці,

- бо расизм – це не думка, а система, яка завдає шкоди людям,

- бо ненависть не може визначати простір, в якому ми живемо,

- тому що рівність і свобода вимагають спільних дій,

- тому що Вроцлав є спільнотою, а різноманітність його мешканців є його силою,

- тому що ми відповідальні за взаємну безпеку – незалежно від кольору шкіри, походження, мови, релігії, орієнтації, ідентичності чи статусу проживання.

Коли: субота, 18 жовтня 2025 року

Час: 14:00–17:30

Старт: Bulwar Dunikowskiego

Візьміть із собою транспарант, інструмент, кольоровий одяг та близьких.

Приєднуйтесь і покажімо, що Вроцлав належить усім!

Приєднаєтеся?

Wrocław para todos, sin odio

Marcha antirracista | 18/10/2025 | 14:00-17:30

Reunámonos para crear juntos un espacio de alegría, solidaridad y apertura. Vengamos con nuestras familias, amigos y vecinos: todos y cada uno de nosotros formamos parte de esta ciudad. Breslavia es el hogar en el que vivimos, a veces por elección, a veces por necesidad, pero siempre con derecho a la seguridad, el respeto y la dignidad.

Nuestra marcha es una manifestación colorida y diversa de comunidad y solidaridad. Es un baile alegre, pero también una postura firme y clara: ante el racismo, la xenofobia, la homofobia, la misoginia y cualquier forma de violencia, elegimos la solidaridad, la igualdad y una vida libre de miedo.

Salimos a la calle

porque el racismo no es una opinión, es un sistema que daña a las personas,

porque el odio no puede definir el espacio en el que vivimos,

- porque la igualdad y la libertad requieren una acción conjunta,

- porque Breslavia es una comunidad y la diversidad de sus habitantes es su fuerza,

- porque somos responsables de nuestra seguridad mutua, independientemente del color de nuestra piel, nuestro origen, idioma, religión, orientación, identidad o estatus de residencia.

Cuándo: sábado, 18 de octubre de 2025.

Hora: 14:00-17:30.

Inicio: Bulwar Dunikowskiego.

Trae contigo una pancarta, un instrumento, ropa de colores y a tus seres queridos.

¡Únete y demostremos que Breslavia pertenece a todos!

¿Te apuntas?

فروتسواف للجميع – بدون كراهية

مسيرة مناهضة للعنصرية | 18 أكتوبر 2025 | 2:00–5:30 مساءً

لنتقابل لنخلق معًا مساحة من الفرح والتضامن والانفتاح. لنأتي مع عائلاتنا وأصدقائنا وجيراننا – فكل واحد منا جزء من هذه المدينة. فروتسواف هي الموطن الذي نعيش فيه، أحيانًا باختيارنا، وأحيانًا بحكم الضرورة، ولكن دائمًا مع الحق في الأمان والاحترام والكرامة.

مسيرتنا هي مظهر ملون ومتنوع للمجتمع والتضامن. إنها رقصة مبهجة، ولكنها أيضًا بيان قوي وواضح: في مواجهة العنصرية وكراهية الأجانب وكراهية المثليين وكراهية النساء وجميع أشكال العنف، نختار التضامن والمساواة وحياة خالية من الخوف.

ننزل إلى الشوارع

لأن العنصرية ليست رأيًا – إنها نظام يضر بالناس

لأن الكراهية لا يمكن أن تحدد المكان الذي نعيش فيه

لأن المساواة والحرية تتطلبان العمل المشترك

لأن فروتسواف هي مجتمع وتنوع سكانها هو مصدر قوتها

لأننا مسؤولون عن سلامة بعضنا البعض - بغض النظر عن لون البشرة أو الأصل أو اللغة أو الدين أو الميل الجنسي أو الهوية أو وضع الإقامة.

الموعد: السبت، 18 أكتوبر 2025

الوقت: 2:00–5:30 مساءً

الانطلاق: Bulwar Dunikowskiego

أحضروا لافتات، وآلات موسيقية، وملابس ملونة، وأحباءكم.

انضموا إلينا ولنُظهر أن فروتسواف ملك للجميع!

هل ستنضمون إلينا؟

#wroclaw #protest #marsz #demonstration #poland #polska #rasizm #antyfaszyzm #racism #antiracism #antifa

MiKlo:~/citizen4.eu$💙💛udostępnił to.

MiKlo:~/citizen4.eu$💙💛udostępnił to.

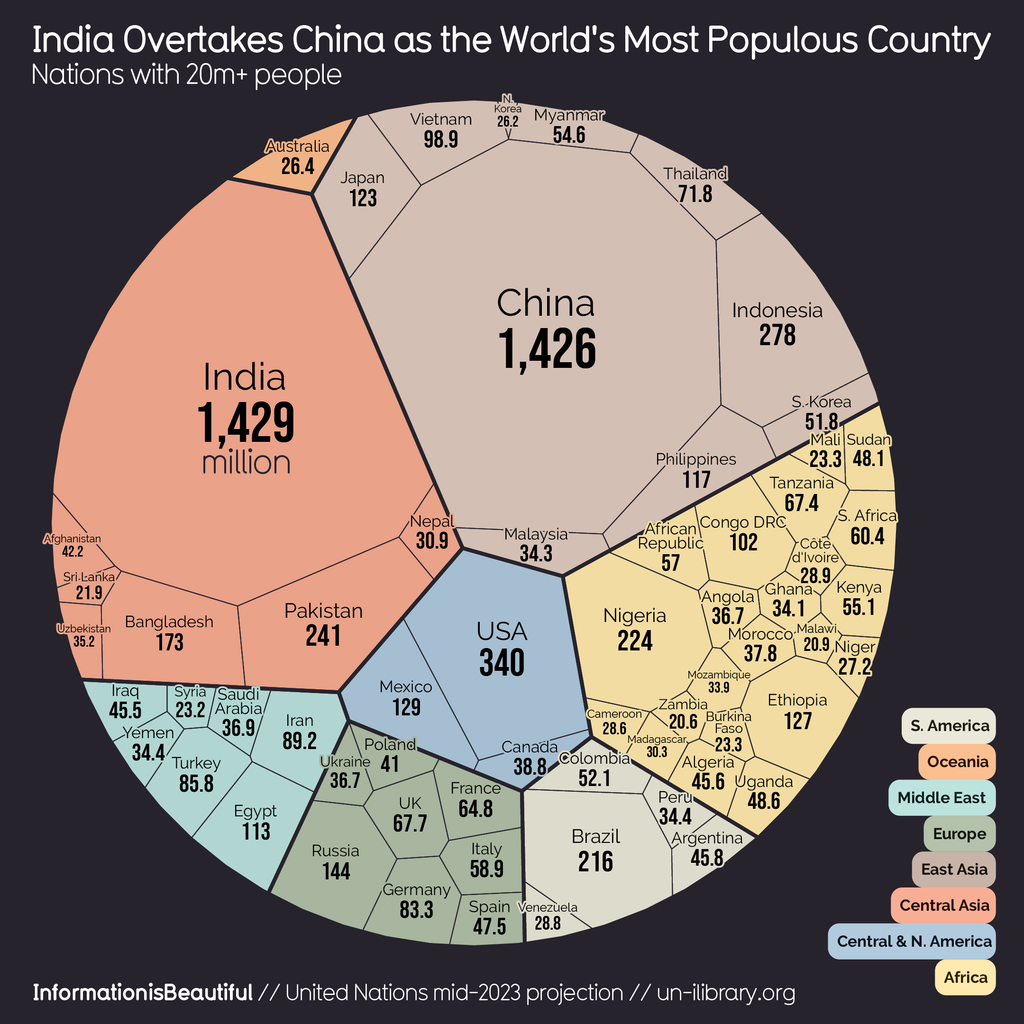

https://informationisbeautiful.net/visualizations/world-population/

World Population — Information is Beautiful

India overtakes China as most populous nationDavid McCandless (Information is Beautiful)

MiKlo:~/citizen4.eu$💙💛udostępnił to.

The area doesn't mean anything.

The angles don't mean anything.

The positioning doesn't mean anything.

How has it been divided up? It's not Voronoi.

MiKlo:~/citizen4.eu$💙💛udostępnił to.

https://www.zdnet.com/article/this-european-military-just-ditched-microsoft-for-open-source-libreoffice-heres-why/

This European military just ditched Microsoft for open-source LibreOffice - here's why

It's not about the cost savings, either. Many government organizations are replacing Microsoft software for a more important reason.Steven Vaughan-Nichols (ZDNET)

MiKlo:~/citizen4.eu$💙💛udostępnił to.

MiKlo:~/citizen4.eu$💙💛udostępnił to.

Planuję rozkręcić telewizję internetową na łamach „Kontrabandy” i póki co głównym roadblockiem są pieniądze. To jest coś, co planowałem od co najmniej kilku tygodni wraz z resztą ekipy.

Crowdfunding niestety idzie słabo -- i niestety raczej bez krótkiego bloku reklamowego przed i/lub po materiałach (z wyłączeniem treści replikowanych od organów państwowych) się nie obędzie.

Szukam sponsorów, którzy są zainteresowani współpracą „na dłużej”. Dopiero się rozwijamy, więc tym bardziej prosiłbym o zrozumienie.

Stawki sponsorskie, warunki itd. do dogadania indywidualnie -- ale na pewno mogę zagwarantować statyczną planszę z logotypem danego sponsora wyświetlaną przez kilka sekund.

Naszym celem jest zebranie łącznie pięciocyfrowej kwoty na start -- tj. sprzęt, biuro o odpowiednim metrażu, założenie i utrzymanie działalności gospodarczej, sformalizowanie redakcji itd.

Jeżeli jesteście zainteresowani -- możecie śmiało pisać na airdrop@kontrabanda.net.

2 użytkowników udostępniło to dalej

Ja Ci jak najbardziej życzę zebrania w/w kwot, ale... będę adwokatem diabła.

Piszesz, że crowdfunding niestety idzie słabo. A ja widzę, że na stronie kontrabandy informacja o wsparciu jest zagrzebana gdzieś na dole strony a informacji o patronite w ogóle tam nie ma i jest dopiero - też na dole - strony o Kontrabandzie.

Jeżeli to oddolne wsparcie jest warunkiem istnienia projektu to informacja jak go udzielić musi być bardziej widoczna. Co najmniej od razu po otwarciu strony, gdzieś na samej górze.

Ze sponsorami to ja widzę dwa problemy:

Jeden jest taki, że ew sponsor będzie chciał mieć gwarancję, że nie zostanie obsmarowany w w jakimś tekście, nawet pośrednio. To raczej wyklucza branże o których potencjalnie chcecie pisać czyli jakieś firmy technologiczne.

Drugi problem to taki, że jak ktoś ma wyłożyć pieniądze to chciałby najlepiej zobaczyć coś więcej niż słowno-muzyczny opis co zamierzacie robić. Zdecydowanie przydałoby się mieć cokolwiek - jakieś pierwsze opublikowane materiały - na dowód, że to przedsięwzięcie "rokuje".

No i jeszcze na koniec kontr-argument, żeby nie zaczynać finansowania od sponsora: finansowanie oddolne wprawdzie oznacza powolny, organiczny wzrost, ale w dłuższym czasie daje większa stabilność i przede wszystkim niezależność.

2 ludzi lubi to

Zresztą fajnie, że w ogóle zwróciłeś uwagę na brakujący link do Patronite'a w stopce (którego dodałem).

A teraz kilka słów odnośnie ew. sponsorów.

Na pewno nie byliby to typowi sponsorzy, że dając pieniądze będą mieli jakikolwiek wpływ w tworzony materiał. Jedyne, co będą mogli otrzymać w zamian za to, że przekażą mi pieniądze, to po prostu kilkusekundowa plansza (może być własnej produkcji, oczywiście po odpowiedniej moderacji) ze statycznym logotypem sponsora, ewentualnie można też byłoby się dogadać pod jakimi konkretnie materiałami ma się pojawiać.

Więc w konsekwencji mielibyśmy to, że -- dajmy na przykład, FTdL, o którym pisaliśmy zresztą dwukrotnie -- gdybyśmy mieli umowę sponsorską z nimi, i nagle wyszłyby brudy na FTdL, to i tak bym mimo wszystko starał się dążyć do wyjaśnienia sytuacji. Czemu ktoś wyciągnął brudy, żeby się sponsor mógł ewentualnie obronić przed zarzutami, a jeżeli wyjaśnienia będą niezadowalające, to po prostu taką umowę rozwiązujemy.

W sumie to można by było porównać do klasycznej telewizji: może i są reklamy np. fast-foodów tamże, ale nie zabrania to stacjom telewizyjnym tworzyć reportaży o szkodliwym wpływie fast-foodów, mimo tego, że technicznie rzecz ujmując, reklamodawca sponsoruje część wypłat pracownikom.

Kontrabanda Play

Oficjalny portal „Kontrabandy” oparty o PeerTube'a, który pozwala Ci obejrzeć materiały wideo tworzone m.in. na podstawie tego, co publikujemy w części tekstowej.Kontrabanda Play

I najważniejsze -- sponsoring by dotyczył wyłącznie części audiowizualnej. Czyli tego, co widzisz na https://play.kontrabanda.net.

I o tym właśnie pisałem - że dopóki tam nic nie ma, w sensie waszych autorskich materiałów, to czym chcecie przekonać ew. sponsora ? Wizją tego co będzie ? To tak nie działa...

Co do widoczności informacji o wsparciu - zobacz jak to działa na stronach dużych projektów mediowych, które są finansowane oddolnie. Np https://oko.press/ albo https://nowyswiat.online/ . Przycisk "Wspieraj" jest cały czas widoczny, niezależnie od formatu strony (desktop/mobilna), również w czasie przewijania.

wyczerpałem wszelkie możliwości jeżeli chodzi o pozyskiwanie nowych, potencjalnych subskrybentów

Możesz wszystkim przypomnieć ilu masz subskrybentów i jeszcze raz przeczytać zdanie które napisałeś ?

Z potencjalnych źródeł finansowania to jeszcze warto się rozejrzeć za mikrograntami, bo to są kwoty zwykle max. 4-ro cyfrowe i często są dostępne nawet dla inicjatyw nieformalnych, chociaż założenie NGO'sa choćby zwykłego stowarzyszenia otwiera większe możliwości. Taki mikrogrant jest jednorazowy więc nie zapewni stałego finansowania ale na ruszenie z miejsca projektu to w sam raz.

@miklo: z Buycoffee.to wpłynęło mi łącznie jakieś 160 PLN po odliczeniu prowizji, z kolei na Patronite na wypłatę oczekuje jakieś 110 PLN, obecnie subskrybentów jest zaledwie 2, którzy płacą łącznie 20 PLN miesięcznie.

Jak za ~300 PLN rozkręcisz od zera projekt (i nie mówię tutaj o projekcie skali Kanału Zero, co tym bardziej bedzie nierealne), chętnie się zainspiruję Twoją historią.

Próbowałem też promować w social mediach, gdzie jesteśmy, nasze kanały crowdfundingowe, jednak nikt nie odpowiedział na nasze publikacje aktywacją subskrypcji. Co robię nie tak?

MiKlo:~/citizen4.eu$💙💛udostępnił to.

4 użytkowników udostępniło to dalej

a Kaczyński tam nie ma jakiejś farmy na której ma swój domek wakacyjny?

Jakieś tam ploty kiedyś słyszałem, ze ma tam jakąś swoją tajną norę...

https://www.youtube.com/watch?v=pRva7z8pvwc

Greatest Line in the History of Comedy

This exchange from Police Squad! contains what I consider the greatest single line in the history of comedy.YouTube

MiKlo:~/citizen4.eu$💙💛udostępnił to.

[OPINIA] Komunikacja w szkołach oparta na komercyjnych rozwiązaniach. Państwo nadal nie reaguje

Ostrzeżenie o treści: Wraz z nowym rokiem szkolnym powróciły stare problemy – w tym także te dotyczące komunikacji nauczycieli z rodzicami. Jedni i drudzy zalogowali się do popularnych komercyjnych aplikacji – bo państwowej alternatywy wciąż brakuje.

2 użytkowników udostępniło to dalej

MiKlo:~/citizen4.eu$💙💛udostępnił to.

Google just asked the Supreme Court to save it from the Epic ruling

It’s asking for a partial stay ahead of its petition for Supreme Court review.Sean Hollister (The Verge)

MiKlo:~/citizen4.eu$💙💛udostępnił to.

MiKlo:~/citizen4.eu$💙💛udostępnił to.

Read coverage from @maria in Flaming Hydra: https://flaminghydra.com/freedom-and-sharing-at-the-internet-archive-europe/

Freedom and Sharing at the Internet Archive Europe

On Friday, in a narrow, cream-painted 17th-century row house facing a wide canal bathed in golden light, the Internet Archive Europe celebrated the opening of its new headquarters in Amsterdam.Maria Bustillos (Flaming Hydra)

2 użytkowników udostępniło to dalej

MiKlo:~/citizen4.eu$💙💛udostępnił to.

Przed chwilą dron zaatakował statek z pomocą humanitarną pod PL 🇵🇱 banderą, na którym płynę. Wszyscy cali, ale uszkodzony został jeden żagiel. Wzywam rząd PL do ochrony flotylli i działań na rzecz zakończenia ludobójstwa w Gazie. Musicie działać teraz!

Edit:

do godz 4: 30 odbyło się 13 ataków, na 10 statków, 3 statki są uszkodzone, w tym ten na którym jestem, który płynie pod polską banderą. 🇵🇱

#GlobalSumudFlotilla #Polska #Gaza

7 użytkowników udostępniło to dalej

Włoski minister obrony Guido Crosetto skierował okręt Marina Militare do wsparcia Global Sumud Flotilla. Stanowczo potępił też nocny atak, w którym ucierpiał m. in. statek pod polską banderą. Czas na reakcję Radka Sikorskiego i Ministerstwa Spraw Zagranicznych RP - na ile jeszcze pozwolicie 🇮🇱?

#AllEyesOnGAZA 🇵🇸

#Gaza #GlobalSumudFlotilla #Polska #Poland

2 użytkowników udostępniło to dalej

MiKlo:~/citizen4.eu$💙💛udostępnił to.

Ktoś, coś?

3 użytkowników udostępniło to dalej

I ten… nie, nie wiem gdzie tam jest ten RSS do audio (kiedyś szukałem i się poddałem), ale @warroza wie :D

Tu: https://joinpeertube.org/news/release-7.1 coś jest (^f podcast) myślę, że to najłatwiejsza opcja.

PeerTube v7.1 is out! | JoinPeerTube

We're excited to release version 7.1 of PeerTube, which continues to evolve graphically, but also to simplify your discoverability! Let's take a close...JoinPeerTube

W sensie wiesz, włączasz na Twoim japcoku aplikację od podcastów i on tam jest.

Z amatorskich rozwiązań skręcanych drutem to może być całkiem spoko…

popytaj w #FTdL, czy nie dałoby się u nich postawić profilu dla siebie.

MiKlo:~/citizen4.eu$💙💛udostępnił to.

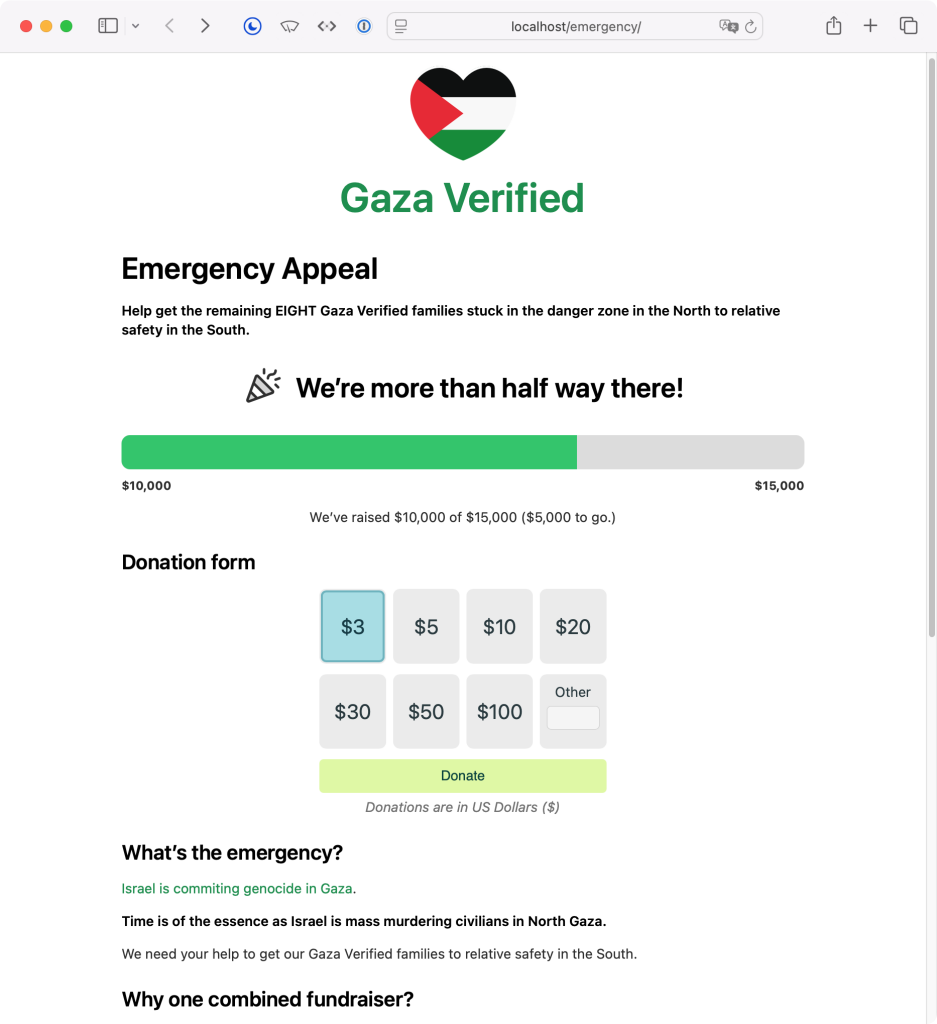

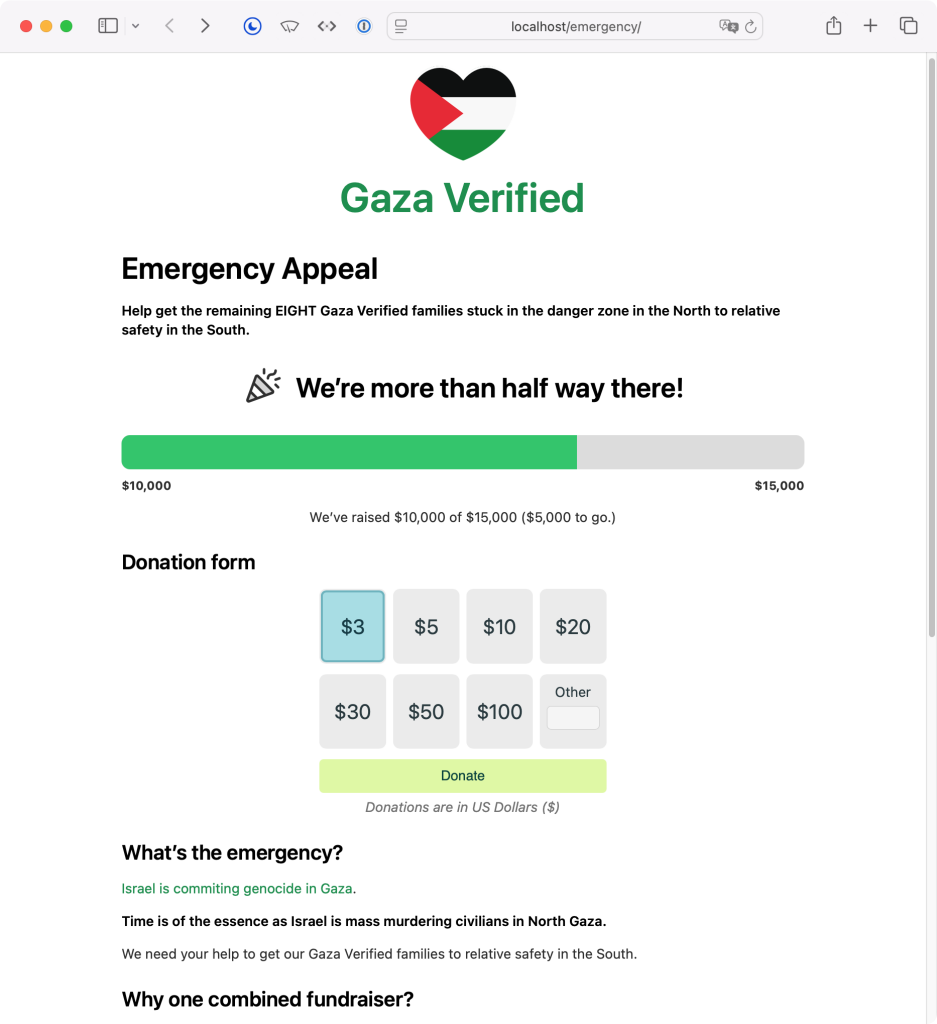

I’m adapting the donation form I’d made for us at Small Technology Foundation (https://small-tech.org/fund-us – don’t worry about donations to us at the moment, eye on the ball, folks!)

Joy’s busy compiling the list of Gaza Verified families that are still stuck in the North and the monies they need to get to the South.

We’re going to add those up and set a total amount and then push that out with a campaign similar to the one I ran last night. I could really use your help once that starts to spread the word and help out if you can.

I don’t have the exact number of families off the top of my head right now (head in code mode) but it’s too many. Even one is too many. Anyway…

So we’re going to collect the donations into our Small Technology Foundation account and then transfer them to everyone’s individual fundraisers. I’ve got that basic functionality running right now (it looks like crap but it’s running so I’m going to work on making the page look more appealing for the rest of the day).

As much as I’d like to start the campaign tonight, realistically, it’s better if we start it tomorrow.

Every night, though, is a chance that we will have fewer families to help…

Anyway, I just wanted to give you a heads up. If you’re around tomorrow, I could use your help in spreading the word.

Thank you all so much for showing our Gaza Verified family so much love already.

I think I’ll be able to breath a little easier once the remaining families in the North are safely in the South.

💕

#GazaVerified #Gaza #Palestine #fediAid #GazaVerifiedEmergencyAppeal

Tio lubi to.

3 użytkowników udostępniło to dalej

MiKlo:~/citizen4.eu$💙💛udostępnił to.

Tematem najbliższego spotkania będzie fonia cyfrowa: DMR, C4FM, D-STAR, TETRA, M17, itd.

Udział w spotkaniach jest bezpłatny. Zachęcamy do przekazania darowizny na rzecz klubu, aby nasze finansować nasze dalsze działania.

Aktualną rozpiskę tematów znajdziecie tutaj: https://forum.hswro.org/t/spotkania-radioamatorskie-w-hackerspace-wroclaw/441

MiKlo:~/citizen4.eu$💙💛udostępnił to.

MiKlo:~/citizen4.eu$💙💛udostępnił to.

We loved keygens back in the day. Our lawyers advise us to clarify that that’s all because of the demo-scene style music embedded in them, not because we used them …read more

#hacking #projects

https://hackaday.com/2025/07/20/remembering-chiptunes-the-demoscene-and-the-illegal-music-of-keygens/

Remembering Chiptunes, The Demoscene And The Illegal Music Of Keygens

We loved keygens back in the day. Our lawyers advise us to clarify that that’s all because of the demo-scene style music embedded in them, not because we used them for piracy. must feel the s…Hackaday

MiKlo:~/citizen4.eu$💙💛udostępnił to.

MiKlo:~/citizen4.eu$💙💛udostępnił to.

Carving a clay stamp, firing it, then using it o stamp the clay while it’s still a little bit soft. It reminds me of the thought process when printmaking.

I’m going to use a celadon style glaze to bring out the texture and beauty of the porcelain clay.

Wheel thrown porcelain

#pottery #handmade #clay #art #kentucky #printmaking #tea #mastoart #craft

MiKlo:~/citizen4.eu$💙💛udostępnił to.

Though, what I'd really like is to see how it feels in the hand!

https://www.invaluable.com/auction-lot/chinese-celadon-glazed-vase-with-handles-230-c-011447b8d6

MiKlo:~/citizen4.eu$💙💛udostępnił to.

https://pluralistic.net/2025/06/30/accounting-gaffs/#artificial-income

Excellent blog by @pluralistic

And lets kick Google out of our classrooms!

#Google #BigTech

MiKlo:~/citizen4.eu$💙💛udostępnił to.

MiKlo:~/citizen4.eu$💙💛udostępnił to.

✊ Replace Meetup/Facebook Groups with Mobilizon:

https://mobilizon.org

📄 Replace Google Docs with CryptPad:

https://cryptpad.fr

📍 Replace Google Map with Organic Maps:

https://organicmaps.app

🎞️ Replace YouTube with PeerTube:

https://joinpeertube.org

📧 Replace Gmail and Google Calendar with Proton or Tuta:

https://proton.me

https://tuta.com

🕸️ Create a simple html website with no tracking and no cookies, and post links to it everywhere, including paper posters and stickers.

We can organize without Big Tech. We have done it for centuries before!

#Protest #Democracy #DigitalRights #HumanRights #Privacy #MassSurveillance

MiKlo:~/citizen4.eu$💙💛 lubi to.

4 użytkowników udostępniło to dalej

Martina Neumayerudostępnił to.

Martina Neumayerudostępnił to.

MiKlo:~/citizen4.eu$💙💛udostępnił to.

Spotkania Radioamatorskie w Hackerspace Wrocław

Udział w spotkaniach jest bezpłatny. Zachęcamy do przekazania darowizny na rzecz klubu, aby nasze finansować nasze dalsze działania.

Aktualną rozpiskę tematów znajdziecie tutaj: https://forum.hswro.org/t/spotkania-radioamatorskie-w-hackerspace-wroclaw/441

2 użytkowników udostępniło to dalej

MiKlo:~/citizen4.eu$💙💛 uczestniczy.

MiKlo:~/citizen4.eu$💙💛udostępnił to.

⚪ Jeśli tworzysz ziny, masz niszowe wydawnictwo, projektujesz gadżety, robisz biżuterię handmade lub szyjesz własne ubrania i chcesz wystawić swoje stoisko na Kongresonie, to ten post jest właśnie dla Ciebie.

A może robisz coś innego i chcesz zgłosić stoisko informacyjne lub dyżur pomocowy? Zapraszamy!

Zapewniamy malutką przestrzeń na stoliki dla wystawców i wystawczyń. Bezpłatnie.

📨 Zgłoszenia przyjmujemy pod adresem: kongresono2019@autistici.org do niedzieli 1 czerwca.

W tytule maila wpisz [Wystawcy].

3 użytkowników udostępniło to dalej

MiKlo:~/citizen4.eu$💙💛udostępnił to.

👉 https://mastodon-listen.playground.54gradsoftware.de/?liste=institute-de

Yes, it's true: we shouldn't get caught up in this nonsensical discussion about #reach of #socialmedia.

On the other hand, it’s a great success 🏆 for initiatives such as #Unis4Mastodon, #Byebyeelon, #WissXit, #SaveSocial, @helloQuitX, @leavex and others that more than 150 research institutions in Germany are contributing to the expansion of the Fediverse.

To our friends in the #USA, we say that we are alarmed at how the new #USpolicy is attacking #science. We are trying to build decentralized and independent #socialnetworks to make our research institutions and democracy resilient to attacks from #autocrats and #hostilitytoscience.

And we think this transformation should happen in other countries, too, to strengthen #democracy.

#SciComm #eXit

Mastodon Listen

Listen von Mastodon-Accounts von z.B. Universitäten, Forschungseinrichtungen etc. Erstellt mit Daten von Wikidata.mastodon-listen.playground.54gradsoftware.de

2 użytkowników udostępniło to dalej

MiKlo:~/citizen4.eu$💙💛udostępnił to.

"What we are doing in Gaza now is a war of devastation: indiscriminate, limitless, cruel and criminal killing of civilians. We're not doing this due to loss of control in any specific sector, not due to some disproportionate outburst by some soldiers in some unit. Rather, it's the result of government policy – knowingly, evilly, maliciously, irresponsibly dictated. Yes, Israel is committing war crimes."

2 użytkowników udostępniło to dalej

MiKlo:~/citizen4.eu$💙💛udostępnił to.

MiKlo:~/citizen4.eu$💙💛udostępnił to.

Being colicky in nature with lifelong PTSD, and an autistic overshare stim, I have been known to put on shows of half coherent rants against Zionism

(A profound one here and there as well)

Always hurts the voice

So I have mostly changed that into breaking out into the O Palestine refrain

It works brilliantly

It's like I'm spraying bug spray: they disappear

MiKlo:~/citizen4.eu$💙💛udostępnił to.

A #watershed #map instead of a political or elevation one.

Imagining a world divided into bio-regions not by some arbitrary political body, but by the rivers and water circulation.

We could make it into a beautiful symbol of a sustainable future.

More about it - https://en.wikipedia.org/wiki/Drainage_divide

The one below is a work of https://www.grasshoppergeography.com/

"A Half Built Garden" book by Ruthanna Emrys implements such a vision!

#geography #drainageBasin #riverBasin

Grasshopper Geography - Artistic maps by a geographer

Shop artistic, yet scientifically accurate maps online! These colorful prints are available in different sizes with worldwide shipping. River maps, forest maps, population and elevation maps all made by a geographer. Perfect gift for nature lovers.Grasshopper Geography

MiKlo:~/citizen4.eu$💙💛udostępnił to.

alxd of the Story Seed Libraryudostępnił to.

https://www.youtube.com/watch?v=Qny4CDcftrI

AMERICA'S BIG MISTAKE: Watershed Democracy REJECTED!

Permaculture instructor Andrew Millison explains how the USA missed the opportunity in 1878 to create political boundaries based on watershed boundaries, and...YouTube

MiKlo:~/citizen4.eu$💙💛udostępnił to.

We passed the Peace Palace, housing the International Court of Justice. And the 18th century lawyer in front of the Dutch Supreme Court had received a 🍉 umbrella.

🟥🟥🟥🟥🟥🟥🟥🟥🟥🟥🟥🟥🟥🟥🟥🟥🟥🟥🟥🟥🟥🟥🟥

#rodelijn #freepalestine #gaza #justice #peace #humanrights 🕊️🇵🇸

MiKlo:~/citizen4.eu$💙💛udostępnił to.

MiKlo:~/citizen4.eu$💙💛udostępnił to.

* It fails to protect migrants or reduce border deaths.

* Is a power grab by Europol.

* It criminalises migrants and solidarity organisers.

We call on MEPs to vote against!

https://protectnotsurveil.eu/

#ProtectNotSurveil

MiKlo:~/citizen4.eu$💙💛udostępnił to.

MiKlo:~/citizen4.eu$💙💛udostępnił to.

Udział w spotkaniach jest bezpłatny. Zachęcamy do przekazania darowizny na rzecz klubu, aby nasze finansować nasze dalsze działania.

Aktualną rozpiskę tematów znajdziecie tutaj: https://forum.hswro.org/t/spotkania-radioamatorskie-w-hackerspace-wroclaw/441

MiKlo:~/citizen4.eu$💙💛udostępnił to.

MiKlo:~/citizen4.eu$💙💛udostępnił to.

Niezależnie od tego, czy masz problem z laptopem, telefonem czy innym sprzętem elektronicznym, członkowie hackerspejsu Knyfyrtel powiedzą czy jest sens naprawy oraz doradzą kolejne kroki.

To doskonała okazja, aby nauczyć się czegoś nowego, wymienić doświadczenia oraz zyskać cenne wskazówki dotyczące konserwacji sprzętu.

Zapraszamy też wszystkie osoby, które mają problemy z instalacją systemów operacyjnych. Dołącz do nas, przynieś swój zepsuty laptop, tablet i wspólnie zróbmy coś dla planety, naprawmy zamiast wyrzucać!

Osoby związane z Po-Dzielnią i Knyfyrtlem będą na Ciebie czekać w godzinach 11-14 w sobotę, 10 maja w budynku MDK nr 1 przy ulicy Droga Dębińska 21 na Wildzie.

---------

Wydarzenie organizowane przez Po-Dzielnia we współpracy z Knyfyrtel Hackerspace Poznań.

MiKlo:~/citizen4.eu$💙💛udostępnił to.

MiKlo:~/citizen4.eu$💙💛udostępnił to.

Decisions affecting our security, privacy & rights can’t be made behind closed doors. Encryption protects us all 🔐

@edri @eff @epic.org @HomoDigitalisGR @panoptykon @privacyint

https://edri.org/our-work/technical-experts-call-on-virkkunen-for-a-seat-on-the-table-european-commissions-technology-roadmap-on-encryption/

Technical experts call on Commissioner Virkkunen for a seat on the table of the European Commission’s Technology Roadmap on encryption - European Digital Rights (EDRi)

EDRi, in a group of 39 organisations and 43 experts, published an open letter today to call for a scientific evidence-based approach to encryption.European Digital Rights (EDRi)

MiKlo:~/citizen4.eu$💙💛udostępnił to.

MiKlo:~/citizen4.eu$💙💛udostępnił to.

“A time machine for the web,” preserving everything from lost government websites to books & records—before they vanish.

🔗 Explore: https://web.archive.org

🎥 Watch ➡️

https://youtu.be/jh98N46DM5k

Can the Internet Archive save our digital history? | BBC News

BBC Tech Now reporter Lily Jamali heads behind the scenes of the Internet Archive.The non-profit organisation based in San Francisco gathers billions of web ...YouTube

MiKlo:~/citizen4.eu$💙💛udostępnił to.

Concerning what Stacy Rosenberg said, I don't see how that follows.

MiKlo:~/citizen4.eu$💙💛udostępnił to.

Jak korzystać z XMPP – zakładanie konta, zapraszanie ludzi, konwersowanie

XMPP istnieje od ponad ćwierć wieku, i przez pewien czas był wykorzystywany przez dużych graczy – mogliśmy rozmawiać z użytkownikami Google Chatu czy Facebook Messengera. I choć obie te firmy już dawno temu się odcięły od XMPP, w tym poradniku na “Kontrabandzie” dowiesz się, jak korzystać z tego standardu do komunikacji. Zróbmy renesans XMPP!

https://kontrabanda.net/r/jak-korzystac-z-xmpp-zakladanie-konta-zapraszanie-ludzi-konwersowanie/

#Cyberbezpieczeństwo #OtwarteOprogramowanie #Poradniki #XMPP

MiKlo:~/citizen4.eu$💙💛 lubi to.

5 użytkowników udostępniło to dalej

No chyba, że wiesz, jak parowanie XMPP z Fediwersum mogłoby wyglądać od strony technicznej – chętnie bym o tym przeczytał.

Na marginesie dodam, że XMPP powstało w 1999 roku, zaś ActivityPub, który obsługuje chyba teraz 95% całej sieci Fediwersum, zostało uznane za standard dopiero w 2018 roku.

Ta forma komunikacji "popularna" (w niszy geeków) była w latach 2001-2006 kiedy to jeszcze o2 wydawało zgodny z XMPP komunikator tlen a #JoggerPL pozwalał na prowadzenie bloga bezpośrednio z komunikatora.

Obecnie w komunikacji wygrała centralizacja i czasy XMPP wydają się zbyt odległe żeby miały szansę powrócić.

https://pl.wikipedia.org/wiki/Tlen.pl

https://pl.everybodywiki.com/JoggerPL

JoggerPL – EverybodyWiki Bios & Wiki

JoggerPL — nieistniejący już system do prowadzenia blogów przez jabbera, oparty początkowo na Joggerze, później rozwijany niezależnie.EverybodyWiki Bios & Wiki

MiKlo:~/citizen4.eu$💙💛udostępnił to.

https://masto.deoan.org/@neurovagrant/114428210057917523

Cory Doctorowudostępnił to.

MiKlo:~/citizen4.eu$💙💛udostępnił to.

Tekst do przeczytania w Dzienniku Gazecie Prawnej i na stronie panoptykon.org:

https://serwisy.gazetaprawna.pl/orzeczenia/artykuly/9786968,dostep-do-danych-bez-zadnej-kontroli.html

https://panoptykon.org/retencja-inne-kraje-ue-wnioski

--

To ostatni dzień, by przekazać

1,5% podatku Fundacji Panoptykon

KRS 0000327613

Dostęp do danych bez żadnej kontroli

W związku z zapowiedzianym ujednolicaniem zasad retencji danych w UE organizacje europejskie boją się pogorszenia ochrony praw. Dla PolskiAnna Obem (GazetaPrawna.pl)

3 użytkowników udostępniło to dalej

MiKlo:~/citizen4.eu$💙💛udostępnił to.

Druga edycja „wolności trzeźwości” prawie dokładnie rok po poprzedniej, uderzy nas wraz z majowym ciepłem lub deszczem. Niesamowicie się z tego cieszymy. Zaczniemy od Sober Stand Up, czyli występu Łukasza z bez kontroli podcast. Ten niesamowity pisarz, muzyk i po prostu człowiek, od kilku lat pokazuje i opowiada o swojej trzeźwej drodze. Robi to także na żywo, i zrobi właśnie u nas.

Potem koncerty, niestety, żaden nowy SxE Hardcore nie powstał, ale są zespoły które chcą grać na takiej imprezie i trzeźwej przestrzeni, a to najważniejsze! Po prawie 2 latach ugościmy znów Różowe Flamingi, tym razem świeżo po wydaniu ich płyty. Już 2 lata temu byli niesamowici, ale teraz to już kosmos. Szczerze emocjonalna mieszanka schoegazowa. A do tego strasze pokolenie zrzeszony w Suchym Pionie – bractwo muzyczno – performatywno – terapeutyczne, czyli szalony rock z domieszkami punku, alternatywy, funku. No a po tym wszystkim, dla wciąż głodnych tańców i tuptania, postaramy się zapewnić techno/elektroniczny after.

Może uda nam się przygotować jeszcze jakieś niespodzianki, kto wie!

Łukasz Kubiak – bez kontroli podcast – Sober Stand Up @bezkontroli.podcast, czyli dobra mordeczka z Bielska Białej, pisarz, muzyk, trzeźwy alkoholik. Trochę się pośmiejemy z prozy życia, może popłaczemy. Łukasz, jako facet dorastający na osiedlowej, wielkiej płycie, wywodzący się z tzw. patologii, osiągnął w życiu więcej niż mógł się spodziewać. A później to przepił. Zaczynał kilka razy od zera. Mówi o tym w prostych, brutalnych, słowach. Jego sober stand up daje mało powodów do śmiechu. Sorry. Not sorry. Ale na pewno sporo do przemyśleń.

https://www.instagram.com/bezkontroli.podcast

Suchy Pion Suchy Pion to grupa / bractwo muzyczno – performatywno – terapeutyczne, powstałe na początku XXI wieku jako ideologiczna opozycja mokrego horyzontalizmu. Zniuansowany styl muzyki Suchego Pionu dociera do grup aktualnie niewrażliwych na wszelkie formy aktywności kulturalno – oświatowej, poprzez krzewienie punk rocka przesiąkniętego ironicznym spojrzeniem na rzeczywistość, pozytywną energią i żywą emocją, co w połączeniu z hipereraktywną choreografią sceniczną porusza świadomością nawet najbardziej wsobne osobniki rodzaju ludzkiego.

https://www.facebook.com/saczypajon/ https://www.youtube.com/watch?v=1yDy1z_30Bo

Różowe Flamingi Świeżo po wydaniu albumu, którego musicie sprawdzić – cudowna mieszkana shoegazu z screamo, dream popem i szczerym pięknym otwarciem wszystkiego co dobre i złe. Kochają swoich fanów, my kochamy ich.

https://instagram.com/stockflamingos https://stockflamingoswehatethemusic.bandcamp.com/album/soundtracks-for-the-high

Techno/Elektroniczny After

Składka 40 zł. Pamiętaj że możesz dać więcej lub mniej. OCSK Postój, Wrocław Ul. Metalowców 59b https://postoj.org/adres-kontakt Przestrzeń bezpieczna i wolna od alkoholu i środków odurzających. Prosimy też o wsparcie nas finansowo, co bardzo pomoże nam działać dalej! https://postoj.org/fund/ Wydarzenie objęte patronatem Stowarzyszenia Nigdy Więcej w ramach akcji Muzyka Przeciw Rasizmowi https://nigdywiecej.org/

3 użytkowników udostępniło to dalej

MiKlo:~/citizen4.eu$💙💛udostępnił to.

Our new report, Automating Authority: Artificial intelligence in EU police and border regimes, maps out how AI is being introduced into immigration, asylum, policing, and criminal justice systems. It is often in secret, with minimal oversight.

MiKlo:~/citizen4.eu$💙💛udostępnił to.

• EU agencies are developing AI tools to profile travellers, assess asylum claims, and conduct biometric surveillance.

• These systems are disproportionately aimed at migrants, racialised communities, and people on the move.

• The EU’s AI Act provides sweeping exemptions for security use, sidestepping fundamental rights protections.

• A powerful new “security AI complex” is emerging, shaped by public-private partnerships, opaque decision-making, and massive public funding

Djoerd Hiemstra 🍉udostępnił to.

This report is our attempt to shift the debate. To expose what's happening. And to ask the most basic democratic questions:

• Who has the power to build these systems?

• In whose interests?

• And who gets to hold them to account?

📓 Read the report: https://www.statewatch.org/automating-authority-artificial-intelligence-in-european-police-and-border-regimes/

✉️ Sign up for updates: https://www.statewatch.org/about/mailing-list/

MiKlo:~/citizen4.eu$💙💛udostępnił to.

No nie :)

Będzie wysyp fajnych maszyn dla Linuksa. Nie wyrzucaj, reinstaluj i używaj dalej.

To pójście ekosystemu Windows w stronę ekosystemu Androida. Producenci nie dostarczają nowej wersji OS, więc musisz kupić nowy telefon.

Jakimś dziwnym sposobem autorzy innych dystrybucji Android potrafią dostarczyć na te telefony nowe wersje. Przykładem LineageOs i wiele jego pochodnych, w tym mój ulubiony /e/Os.

Microsoft pozazdrościł producentom telefonów i próbuje tego samego z pecetami. Wyrzucić 3-letni fajny sprzęt i kupić nowy? Niedoczekanie.

Pamiętaj, kilkuletnie maszyny, czy to telefon, laptop czy blaszak, świetnie działają, można je naprawić, rozbudować, wymienić baterie, dodać ram czy szybszy dysk. Czy przeinstalować system operacyjny.

Sam na co dzień pracuję na laptopie, który ma ładnych kilka lat, dołożoną pamięć, nowy dysk, stację dokującą i 2 dodatkowe monitory. To samo telefony i tablety (mam ich kilka, ze względu na pracę). Drugi, zapasowy ThinkPad jest jeszcze starszy i świetnie działa (oba na linuksie). Podobnie serwer w domowym labie to starsza, świetna maszyna.

Nie daj się robić w balona.

#Repair #Reinstall #Reuse

Poczytasz o działaniach MS m. in. tu:

https://www.forbes.com/sites/zakdoffman/2025/04/05/microsoft-warns-240-million-windows-users-stop-using-your-pc/

#Microsoft #Windows #waste #NoWaste #ZeroWaste

Microsoft Warns 240 Million Windows Users—Stop Using Your PC

All change for PC owners as deadline gets closer.Forbes

9 użytkowników udostępniło to dalej

do 5a jeszcze backportują łatki bezpieczeństwa, ale to tyle - nie ma dłuższego wsparcia w nim niż od samego google (nie dostanie już Androida 16 i jak ten wyjdzie, to GOS też przestanie go wspierać)

MiKlo:~/citizen4.eu$💙💛udostępnił to.

"Projektowanie oprogramowania jest kluczowe dla ochrony środowiska i trwałości produktów i sprzętu. Systemy i usługi będące Wolnym Oprogramowaniem pozwalają na ponowne użycie, zmianę przeznaczenia i interoperacyjność urządzeń. Prawo do wyboru systemu operacyjnego, oprogramowania i usług jest niezbędne w tworzeniu bardziej zrównoważonego społeczeństwa cyfrowego."

https://fsfe.org/activities/upcyclingandroid/openletter.pl.html

Polskie tłumaczenie: @エインドゥロイドゥ

#foss #fsfe

List otwarty – Prawo do instalacji dowolnego oprogramowania na każdym urządzeniu - FSFE

Free Software Foundation Europe is a charity that empowers users to control technology. We enable people to use, understand, adapt, and share software.FSFE - Free Software Foundation Europe

28 ludzi lubi to

35 użytkowników udostępniło to dalej

podmienimy sobie język :)

podmienimy sobie język :)![Headline from an opinion column by Ehud Ohlmert, a former Prime Minister of Israel, published today in Haaretz:

"Enough is enough. Israel is committing war crimes."

Sub-headline:

"Recent operations in the Gaza Strip have nothing to do with legitimate war goals. This is now a private political war."

[picture - a view across the rubble of destroyed buildings somewhere in Gaza]

Headline from an opinion column by Ehud Ohlmert, a former Prime Minister of Israel, published today in Haaretz:

"Enough is enough. Israel is committing war crimes."

Sub-headline:

"Recent operations in the Gaza Strip have nothing to do with legitimate war goals. This is now a private political war."

[picture - a view across the rubble of destroyed buildings somewhere in Gaza]](https://soc.citizen4.eu/photo/preview/1024/3558728)

Kid Mania

•Right on cue. Because of course it fucking is.

☠️ 🇺🇸 ☠️

#doomed

a fish named dog 🎗️✡️♾️

•ChookMother 🇦🇺🦘

•#uspol

Poloniousmonk

•https://theneuralconnection.com/2024/08/29/concussion-eye-test-with-flashlight-how-to/

Concussion Eye Test with Flashlight: A Comprehensive Guide

The Neural Connectionyodaladywhooo

•YaaRao

•📜 100+ rare vintage illustrations

⚡ Just $2.99 | Instant download

👉 https://payhip.com/b/WoZE7 Grab your time machine now!

#RetroFuture #VintageArt #Futurism #TimeTravel #Ebook #HistoryLovers #HistoricalArt #Steampunk #SciFiArt #IndieAuthor #BookLovers #CollectorsEdition #MindBlowing

Visions of 2000: Retro-Futurist Dreams at the Turn of the Century

PayhipAoi_X_Kaizaki

•YaaRao

•📜 100+ rare vintage illustrations

⚡ Just $2.99 | Instant download

👉 https://payhip.com/b/WoZE7 Grab your time machine now!

#RetroFuture #VintageArt #Futurism #TimeTravel #Ebook #HistoryLovers #HistoricalArt #Steampunk #SciFiArt #IndieAuthor #BookLovers #CollectorsEdition #MindBlowing

Visions of 2000: Retro-Futurist Dreams at the Turn of the Century

Payhipxs4me2

•Kerplunk

•ICE is the gangmasters hitmen group, the new Gestapo, no morals, guidlines from the orange madman just do it... nobody is safe from such a group.

Toni Aittoniemi

•Democratic Socialist BillJRyan

•Cvsdestroyer

•Rubysavage

•